robots协议禁止收录网站某一篇文章地址

发布时间:2021-10-20 15:57:42 本站作者 【 字体:大 中 小 】 浏览:244 次

网站 robots.txt 文件配置方法,如何禁止搜索引擎收录指定网站某一篇超链接地址呢,今天跟着麦站一起学学吧。

搜索引擎通过网络蜘蛛抓取网页的内容,并展示在相关的搜索结果中。但是有些网页内容我们可能并不想被搜索引擎收录和索引,如管理员后台等。

我们就可以通过 robots.txt 文件来声明允许/禁止搜索引擎的蜘蛛抓取某些目录或网页,从而限制搜索引擎的收录范围。

什么是 robots.txt

Robots是站点与spider沟通的重要渠道,站点通过robots文件声明本网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。

Robots.txt用法:

User-agent:用于指定指令所作用于的目标抓取工具(网络蜘蛛),后接抓取工具名称;

Disallow:指定不允许抓取的目录或网页,后面为空则表示允许抓取一切页面;

Allow:指定允许抓取的目录或网页;

Sitemap:站点地图的位置,必须是绝对路径;

*:表示通配符;

$:表示网址结束;

/:匹配根目录以及任何下级网址。

禁止抓取某一个超链接:

Disallow: /news/hangyejishu/43.html

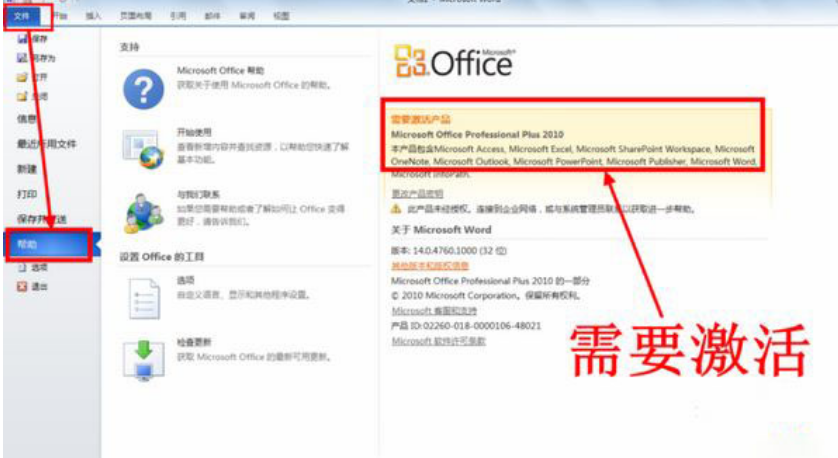

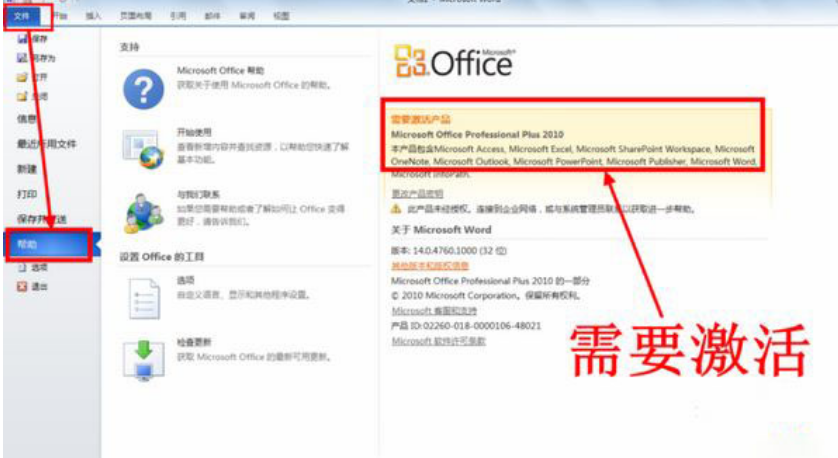

Office2024激活密钥分享_2025年永久激活密钥分享及激活工具分享

office2022激活密钥免费激活2026新版

office2022激活密钥,永久激活码office2022,希望对大家有帮助

office2022激活秘钥,office2022激活教程全部过程

Office2024激活密钥分享_2025年永久激活密钥分享及激活工具分享

office2022激活密钥免费激活2026新版

office2022激活密钥,永久激活码office2022,希望对大家有帮助

office2022激活秘钥,office2022激活教程全部过程

office365激活密钥2023最新-office365激活密钥永久有效大全

office2023激活密钥大全,office 2023激活密钥【亲测可用】

最新版Office 2024破解版一键安装永久使用,可密钥永久激活

来了,Office 2024 LTSC版下载、安装、激活全教程

Office2024正式版 KMS激活(无需激活工具),office2024激活方法

Office2024密钥被分享出来,直接Office 2024永久激活码!次数1万次,人多数量有限!